KI-generierte Inhalte nehmen überhand, verdrängen menschliche Kreativität und gefährden die Existenz vieler Webseiten, die von Menschen gemacht werden.

Spam erreicht ein neues Niveau an Relevanz und die KI zerstört das Netz – und sich letztendlich selbst.

Artikel-Inhalte:

- KI-Fortschritt zwischen Fakt und Fiktion

- Verblödung durch KI-Slops?

- Alarmierende Fehlerquoten bei populären KI-Chatbots

- Wie KI uns vom Denken befreit

- Chatbots und die psychische Gesundheit

- Immer mehr KI-generierte Online-Artikel

- Die KI zerstört das Netz – und sich letztendlich selbst

- Der “Golden Retriever Effekt“

- Spam erreicht ein neues Niveau an Relevanz

- Die Idee des freien Internets verschwindet

- Die Folgen für uns alle

- FAZIT

KI-Fortschritt zwischen Fakt und Fiktion

Mit dem rasanten Fortschritt auf dem Gebiet der Künstlichen Intelligenz ( kurz: KI, engl. AI ) öffnet sich für viele Menschen ein vollkommen neuer Zugang zu Wissen. Insbesondere Chatbots wie ChatGPT ermöglichen es, in Sekundenschnelle riesige Mengen an Informationen abzurufen, komplexe Fragestellungen zu klären und sogar kreative Inhalte zu generieren.

In unserer digitalen Ära ist die Grenze zwischen Fakt und Fiktion verschwommener geworden.

Künstliche Intelligenz wird in unserer Gesellschaft immer wichtiger und verändert grundlegend unseren Umgang mit Wahrheit und Authentizität.

Verdummt unsere Gesellschaft durch den Einsatz von KI?

Oder werden wir gerade Zeuge des nächsten evolutionären Schrittes?

Verblödung durch KI-Slops?

Mit "KI-Slop" (AI‑Slop) werden minderwertige, KI‑generierte Inhalte bezeichnet.

KI-Slop-Inhalte wirken auf den ersten Blick stimmig, sind aber oft inhaltlich falsch, veraltet oder fachlich einfach unbrauchbar.

Die KI verfügt über riesige Datenmengen, berücksichtigt jedoch keine Quellenbewertungen und kennt keine Kontexte. Die trügerische Detailtiefe erweckt den Anschein von Kompetenz, die in Wirklichkeit nicht vorhanden ist.

Wer solche Informationen ungeprüft übernimmt — sei es in Kundenbriefings oder bei Gesprächen mit Kolleginnen und Kollegen — riskiert nicht nur falsche Entscheidungen, sondern auch den Verlust des Vertrauens gegenüber echten Fachleuten.

Immer extremer, immer verrückter, immer chaotischer.

Hauptsache, es werden in großer Zahl Klicks generiert.

Die Algorithmen von Meta und anderen Unternehmen verbreiten derartige Inhalte über die digitalen Kanäle – mit ernsthaften Folgen: Fake News, Urheberrechtsverletzungen und der Verlust des kollektiven Verständnisses von Realität.

Der Comedian John Oliver bringt das Problem mit Humor und Beispielen auf den Punkt: AI Slop ist nicht nur lästig, sondern auch potenziell gefährlich. Zu sehen hier auf YouTube: https://youtu.be/TWpg1RmzAbc

Alarmierende Fehlerquoten bei populären KI-Chatbots

Millionen Deutsche nutzen täglich KI-Chatbots als Informationsquelle. Allein ChatGPT wird weltweit von 800 Millionen Menschen jede Woche verwendet. Für viele haben diese digitalen KI-Assistenten die herkömmliche Google-Suche bereits ersetzt.

Doch hier entsteht bereits der erste große “KI-Slop”. In einer aktuellen Studie der Europäischen Rundfunkunion (EBU) wurde systematisch die Zuverlässigkeit der populärsten KI-Systeme getestet.

Das beunruhigende Ergebnis: ChatGPT, Claude, Gemini und weitere Chatbots erfinden bis zu 40 Prozent ihrer Antworten und präsentieren diese als Tatsachen.

Ein weiteres Problem ist die Glaubwürdigkeit etablierter Medien. Chatbots geben immer wieder an, ihre erfundenen Angaben stammten von ARD, ZDF oder der Tagesschau, obwohl diese Redaktionen nie darüber berichtet haben — oder ganz anders berichtet haben. Wenn KI deren Namen für Falschinformationen missbraucht, verlieren Nutzer das Vertrauen in verlässliche Quellen.

KI ersetzt keine Fachkompetenz

Wie KI uns vom Denken befreit

Immer mehr Menschen nutzen KI-Tools im privaten und beruflichen Alltag. Doch Forscher warnen zunehmend vor einer Verkümmerung des menschlichen Gehirns (Quelle: mit media lab).

Besonders gefährdet: Kinder und Schüler.

Die Wissenschaftler sprechen von einer “kognitiven Verzerrung” durch häufige KI-Nutzung. Gehirnscans zeigen verminderte Aktivität in Bereichen, die für komplexes Denken und Gedächtnisbildung zuständig sind.

KI-Tools nehmen ihren Nutzern zunehmend das Denken ab.

Zwischen Bequemlichkeit und geistiger Erosion entsteht ein Teufelskreis: Je smarter die KI, desto stärker verkümmert das Gehirn – zumindest, wenn man sich dessen nicht bewusst ist.

KI-Werkzeuge wie ChatGPT verändern unsere Denk- und Lernweisen. Zwischen Unterstützung und mentaler Faulheit gibt es nur eine kleine Grenze – und genau diese bestimmt, ob unser Gehirn sich weiterentwickelt oder zurückbildet.

Ohne kritisches Hinterfragen erspart jede Antwort von ChatGPT und Co. einen Umweg durch das eigene Gehirn. Doch genau durch dieses Ringen mit Irrtum und Zweifel formt sich echte Intelligenz. Denken darf nicht zu einer ausgelagerten Dienstleistung werden.

Wer der Künstlichen Intelligenz (KI) zu viel überlässt, lässt eigene Synapsen verkümmern.

Hirnareale schwächen sich ab, wenn Fähigkeiten nicht regelmäßig genutzt werden. So wie der Taschenrechner mathematisches Denken verdrängt, kann die KI analytische Denkarbeit verdrängen.

Die KI kann dabei helfen, Struktur ins Lernen zu bringen, solange sie nicht das Denken ersetzt.

Chatbots und die psychische Gesundheit

Viele Menschen, die mit Chatbots kommunizieren, zeigen Anzeichen von Psychosen, haben Suizidabsichten oder entwickeln eine emotionale Abhängigkeit.

Einige aktuelle Modelle reagieren nicht angemessen auf Suizidabsichten oder Wahnvorstellungen. Die teils katastrophalen Antworten von KI-Modellen (Chatbots) und ihre fatalen Folgen sind gut dokumentiert (Quelle: SMWB).

Besonders anfällig sind auch hier wieder Kinder und Jugendliche.

Immer mehr KI-generierte Online-Artikel

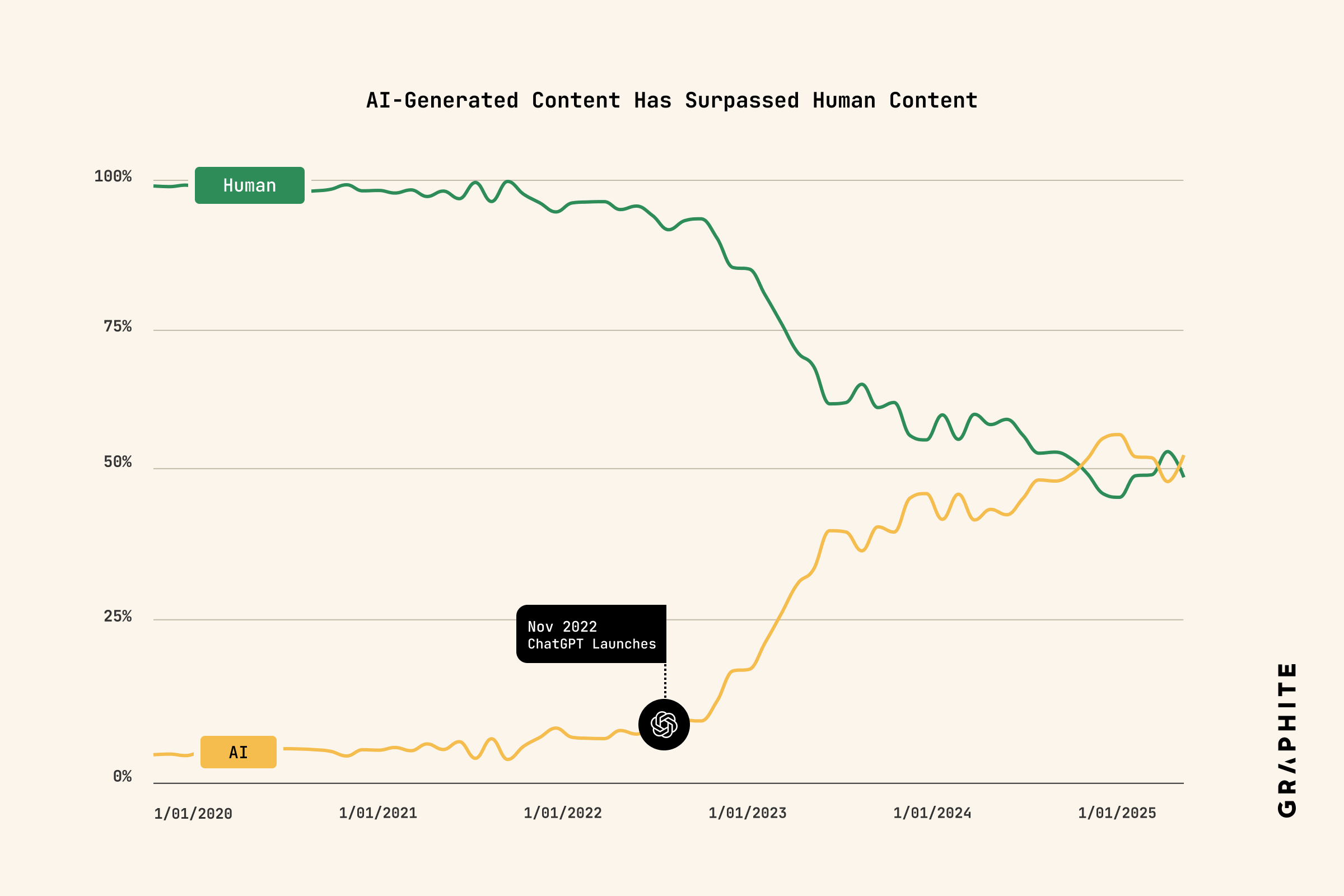

Laut einer aktuellen Studie von Graphite produzieren KI-Systeme mittlerweile mehr neue Online-Artikel als echte Menschen.

Grafik-Quelle: Studie von Graphite

Über die Hälfte der frisch publizierten englischsprachigen Web-Artikel stammt aus der Maschinenfeder – vor allem Affiliate-Sites, Clickbait-Farmen und schreibfaule Publisher fluten das Netz damit.

Allerdings: Sichtbar ist davon wenig. Die meisten KI-Texte tauchen weder bei Google noch in ChatGPT-Antworten auf – die Algorithmen bevorzugen weiterhin menschliche Inhalte. Gut für die Blogger und Journalisten unter uns.

Aber: die Qualität von KI-erzeugten Inhalten verbessert sich rasant. In zahlreichen Fällen sind Texte, die von KI erstellt wurden, genauso gut oder sogar besser als menschliche Beiträge (Quelle: MIT-Studie).

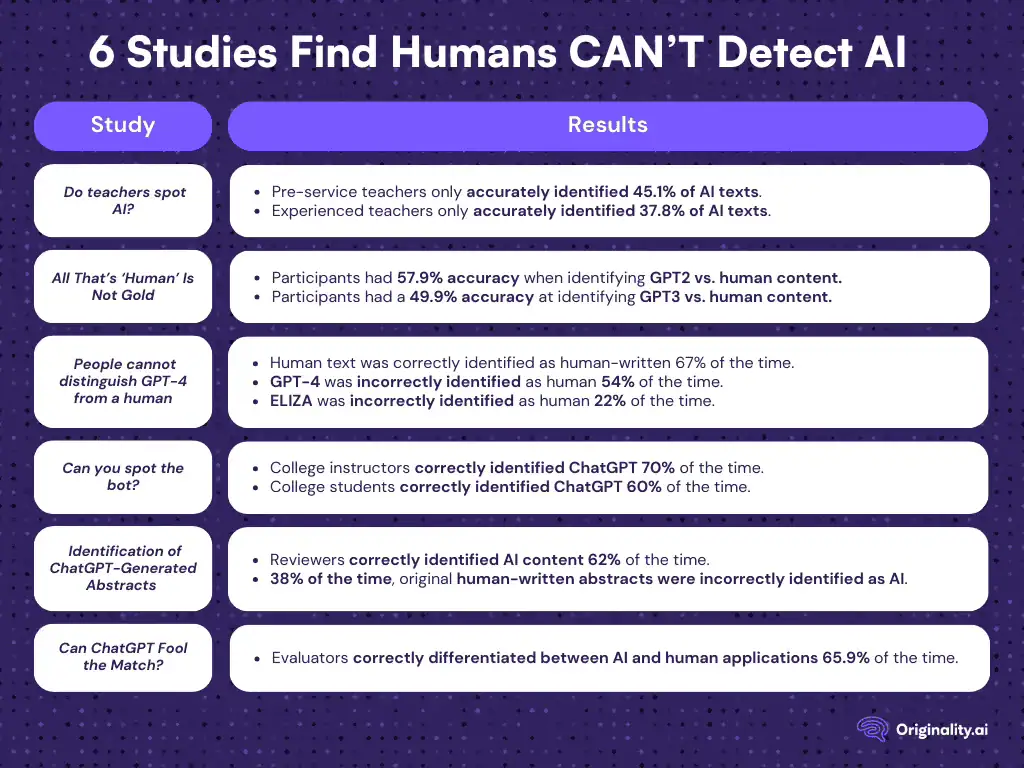

Für Menschen ist es häufig schwer zu erkennen, ob Inhalte von einer KI stammen (Quelle: Originality AI-Studie).

Die KI zerstört das Netz – und sich letztendlich selbst

Texte, Bilder und ganze Webseiten werden heute massenhaft von KI generiert. Was früher aufwendige redaktionelle Arbeit erforderte, lässt sich in Sekunden maschinell erzeugen.

Doch was nach Effizienzgewinn aussieht, birgt ein tiefgreifendes strukturelles Risiko: Die KI lernt aus dem Netz – und dieses Netz besteht zunehmend aus KI-generierten Inhalten.

Das bedeutet, um so mehr KI-generierte Inhalte um so mehr Falschbehauptungen, gefakte Bilder, falsche Texte und Halluzinationen entstehen.

Eine Studie von Ilia Shumailov und Zakhar Shumaylov (University of Oxford), veröffentlicht im Fachjournal Nature, macht die Folgen deutlich: Wird die KI mit von anderen KIs erzeugten Daten trainiert, nimmt die Qualität der erzeugten Inhalte stark ab. Schon nach wenigen Trainingszyklen werden die Ergebnisse kaum noch verständlich.

Dieses Phänomen – die Maschine lernt aus ihren eigenen Ausgaben und verschlechtert sich dabei – könnte zur Realität des Internets werden.

Der “Golden Retriever Effekt“

Ähnlich verhält es sich bei der Bildgenerierung mit dem sogenannten “Golden-Retriever-Effekt“: Ein Phänomen, bei dem durch wiederholtes Training mit bereits von der KI erzeugten Bildern die Vielfalt allmählich abnimmt.

Beispiel: Wird eine KI zunächst mit Bildern verschiedener Hunderassen trainiert, kann sie diese gut nachbilden. Verwendet man jedoch ihre eigenen Ausgaben erneut als Trainingsdaten, setzt sich nach und nach das am häufigsten Gezeigte und das Durchschnittliche durch – etwa der Golden Retriever.

Dieses Phänomen ist nicht nur auf Hunde beschränkt, sondern kann auch bei anderen Objekten, Stilen oder Konfigurationen auftreten. Es stellt eine Herausforderung für die kreative Anwendung von KI-Bildgeneratoren dar, insbesondere wenn man eine große Bandbreite an Bildern erzeugen möchte.

Seltene oder ungewöhnliche Merkmale verschwinden. Die Ergebnisse werden eintönig und austauschbar.

Auf Texte übertragen heißt das: Vielfalt, Nuancen und Tiefe gehen verloren.

Die Folge: eine digitale Verdummung.

Spam erreicht ein neues Niveau an Relevanz

Gleichzeitig tauchen immer mehr gefälschte Webseiten auf, die automatisch von KI erzeugte Inhalte publizieren – häufig ohne menschliche Kontrolle oder redaktionelle Qualitätsprüfung.

Was früher als bloßer „Spam“ galt, gewinnt jetzt zunehmend an Bedeutung, da die Suchmaschinen häufig Probleme haben, menschliche und maschinelle Inhalte voneinander zu unterscheiden.

Die Idee des freien Internets verschwindet

Das Internet ist nicht mehr das Netz, das es einmal war.

Es gibt kaum noch Gründe, überhaupt noch echte Inhalte zu veröffentlichen. Wo früher Sichtbarkeit und Traffic lockten, bringen heute KI-Zusammenfassungen (wie etwa bei Google) dazu, dass Nutzer gar nicht mehr auf die Originalseiten klicken.

Die einstige Win‑win‑Situation «Inhalt gegen Aufmerksamkeit» droht zu kippen.

Immer mehr hochwertige Inhalte landen hinter Bezahlschranken. Neuer, besonders qualitativ guter Content menschlicher Autoren verschwindet zunehmend aus frei zugänglichen Bereichen.

Große, offene Plattformen wie Reddit, Wikipedia oder viele Online-Foren beobachten und befürchten diesen Trend bereits: Minderwertige, KI-generierte Texte überschwemmen ihre Seiten.

Das mindert nicht nur die Inhaltsqualität, sondern birgt auch die Gefahr, dass KI-Scraper diese maschinell erstellten Beiträge als Vorlage für neue Texte nutzen — ein Teufelskreis, der das freie Internet letztlich in eine Müllhalde mit schlechten KI-Texten verwandeln könnte.

Das Internet war mal ein offener Marktplatz der Ideen: frei zugänglich, kollaborativ, demokratisch.

Als das Internet seine Blütezeit erlebte, bot es Menschen die Chance, sich weltweit ohne großen Zeit- oder Geldaufwand zu vernetzen und zu informieren. Dieses auf den Prinzipien der Vernunft und des rationalen Dialogs basierte Ideal einer Plattform scheint jedoch zu verschwinden.

Die Folgen für uns alle

Eigentlich Paradox: Nie war es leichter, Inhalte zu erstellen – und gleichzeitig war die Substanz des Internets wohl nie so gefährdet wie heute.

Eine Abwärtsspirale der Qualität, angetrieben von selbstreferenziellen KI-Systemen, könnte bereits in absehbarer Zeit gravierende Folgen haben.

Die Verbindung aus sinkender inhaltlicher Qualität im offenen Netz und der zunehmenden Abschottung guter Inhalte hinter Paywalls droht die ursprüngliche Idee des Internets zu untergraben.

Prognosen zufolge könnte dieser Effekt bereits innerhalb der nächsten fünf bis acht Jahre spürbar werden – vielleicht sogar früher, falls sich die Verbreitung Künstlicher Intelligenz weiterhin rasant beschleunigt.

Das vorhandene Wissen würde dann nicht mehr aktualisiert oder erweitert, sondern lediglich kopiert und verzerrt. Die Qualität des Wissens würde kontinuierlich abnehmen.

Statt intelligenter zu werden, besteht die Gefahr, dass die Menschheit durch ihre eigene (KI-)Technologie verkümmert.

Durch die KI-Technologien besteht die Gefahr, dass kritisches Denken verkümmert. Wer die Antworten von ChatGPT und Co. nicht hinterfragt, riskiert, dass Wahrheit auf der Strecke bleibt – KI-Halluzinationen inklusive.

FAZIT

Falschinformationen breiten sich in sozialen Medien schnell aus, weil Nutzer KI-erstellte „Fakten“ ohne Prüfung weiterverbreiten. Schüler sowie Studierende übernehmen erfundene Inhalte in ihren Arbeiten. Bürger könnten ihre Wahlentscheidungen auf Grundlage falscher Behauptungen treffen. Besonders heimtückisch: Viele Nutzer sind sich gar nicht bewusst, dass Chatbots Halluzinationen erzeugen können.

Das Problem steckt im System: Chatbots begreifen nicht wirklich, was sie äußern. Sie ermitteln anhand großer Textmengen, welche Wörter wahrscheinlich zusammengehören. Ob das Ergebnis tatsächlich stimmt, können sie nicht prüfen. Sie besitzen kein sachliches Wissen, sondern nur statistische Muster.

Die Lösung: Nie blind vertrauen. Wichtige Informationen stets überprüfen.

Für kreative Aufgaben oder als Schreibhilfe können KI-Tools, bzw. Chatbots ganz praktisch sein. Als Faktenchecker oder Nachrichtenquelle taugen sie nicht. Zumindest sollte sich niemand zu 100 Prozent darauf verlassen. Bei Nachrichten und Fakten immer auf etablierte Medien zurückgreifen, nicht auf die KI. Besonders bei politischen Themen, Gesundheitsfragen oder finanziellen Entscheidungen ist Vorsicht angebracht.

Die KI kann das Lernen schneller, individueller und einfacher machen. Allerdings besteht die Gefahr, dass das Auslagern des Lernens an Maschinen zu geistiger Passivität führt.

Was ist Deine Meinung dazu?

Was hältst du von den Auswirkungen der KI auf das menschliche Gehirn?

Verkümmert das menschliche Gehirn durch die KI?

Kein Spam, keine Weitergabe an Dritte. Nur du und ich.

Mitgliederdiskussion